Supervisión y monitoreo en-línea del comportamiento de sistemas autónomos

Importancia – Con la creciente tendencia a incrementar significativamente los niveles y tipos de automatización de muchos sistemas artificiales o agentes con seguridad crítica tales como el coche autónomo, los drones, el páncreas artificial y los robots industriales cognitivos es imprescindible desarrollar nuevas metodologías y enfoques que permitan monitorizar en tiempo real el comportamiento de los mismos. Sin una capa abstracta de supervisión y monitoreo permanente de un sistema autónomo es poco probable que la promesa de una “inteligencia artificial en todos lados,” puede materializarse pronto. Las personas sólo aceptarán estos nuevos niveles de autonomía si existen embebidas en el sistema funciones de supervisión y control del comportamiento de un sistema autónomo que permitan garantizar no sólo eficiencia y eficacia sino principalmente la seguridad, aún ante escenarios imprevistos o de muy baja probabilidad de ocurrencia.

Importancia – Con la creciente tendencia a incrementar significativamente los niveles y tipos de automatización de muchos sistemas artificiales o agentes con seguridad crítica tales como el coche autónomo, los drones, el páncreas artificial y los robots industriales cognitivos es imprescindible desarrollar nuevas metodologías y enfoques que permitan monitorizar en tiempo real el comportamiento de los mismos. Sin una capa abstracta de supervisión y monitoreo permanente de un sistema autónomo es poco probable que la promesa de una “inteligencia artificial en todos lados,” puede materializarse pronto. Las personas sólo aceptarán estos nuevos niveles de autonomía si existen embebidas en el sistema funciones de supervisión y control del comportamiento de un sistema autónomo que permitan garantizar no sólo eficiencia y eficacia sino principalmente la seguridad, aún ante escenarios imprevistos o de muy baja probabilidad de ocurrencia.

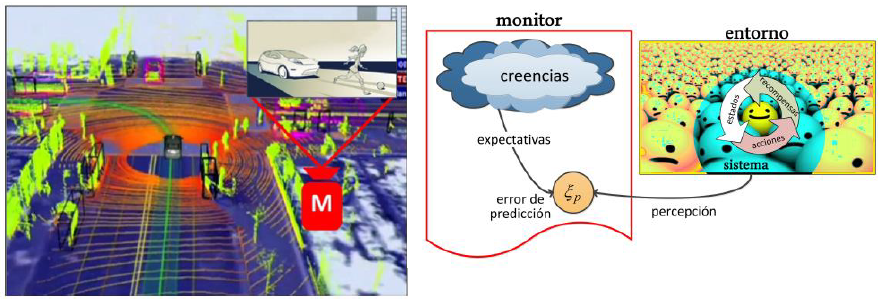

Problemática – La mayor dificultad para monitorizar el comportamiento de un sistema autónomo es que el mismo es un agente situado en un entorno incierto y variante en el tiempo, sobre el que influye y le influye en respuesta a las acciones que toma. El comportamiento es por tanto una emergencia no sólo de la política de actuación del sistema sino de cómo el entorno que, además de objetos, contiene otros agentes que de una u otra manera responden a las acciones que toma el sistema autónomo. Más aún, como normalmente el sistema autónomo posee la capacidad de aprender su política de actuación, su comportamiento se adapta y evoluciona constantemente.

Objetivos – Desarrollo y ensayo computacional usando simuladores de un enfoque Bayesiano donde se integran la inferencia activa y el uso de simulaciones mentales de la evolución del estado interno del agente y la situación del entorno como se indica en la Figura. La simulación mental utiliza una representación “intuitiva” de la física asociada al entorno que permite un razonamiento de sentido común acerca de la evolución dinámica de la escena o situación en que está inmerso el agente. La inferencia activa por su parte consiste en una representación probabilística de las distintas hipótesis que explican el comportamiento observado del agente. Además, el plan contempla utilizar representaciones profundas (Deep learning) para favorecer el entrenamiento intensivo del monitor y el uso de interpretaciones semánticas de la escena observada.

Contacto: Dr. Ernesto C. Martínez (ra.vo1714055307g.tec1714055307inoc-1714055307efatn1714055307as@ra1714055307gnIsa1714055307ceb1714055307)